mirror of

https://github.com/Colin-XKL/Colinx-Blog.git

synced 2026-01-12 18:51:28 +08:00

Compare commits

1 Commits

text-lint

...

7c8d03737f

| Author | SHA1 | Date | |

|---|---|---|---|

|

|

7c8d03737f |

@@ -35,11 +35,11 @@ tags:

|

|||||||

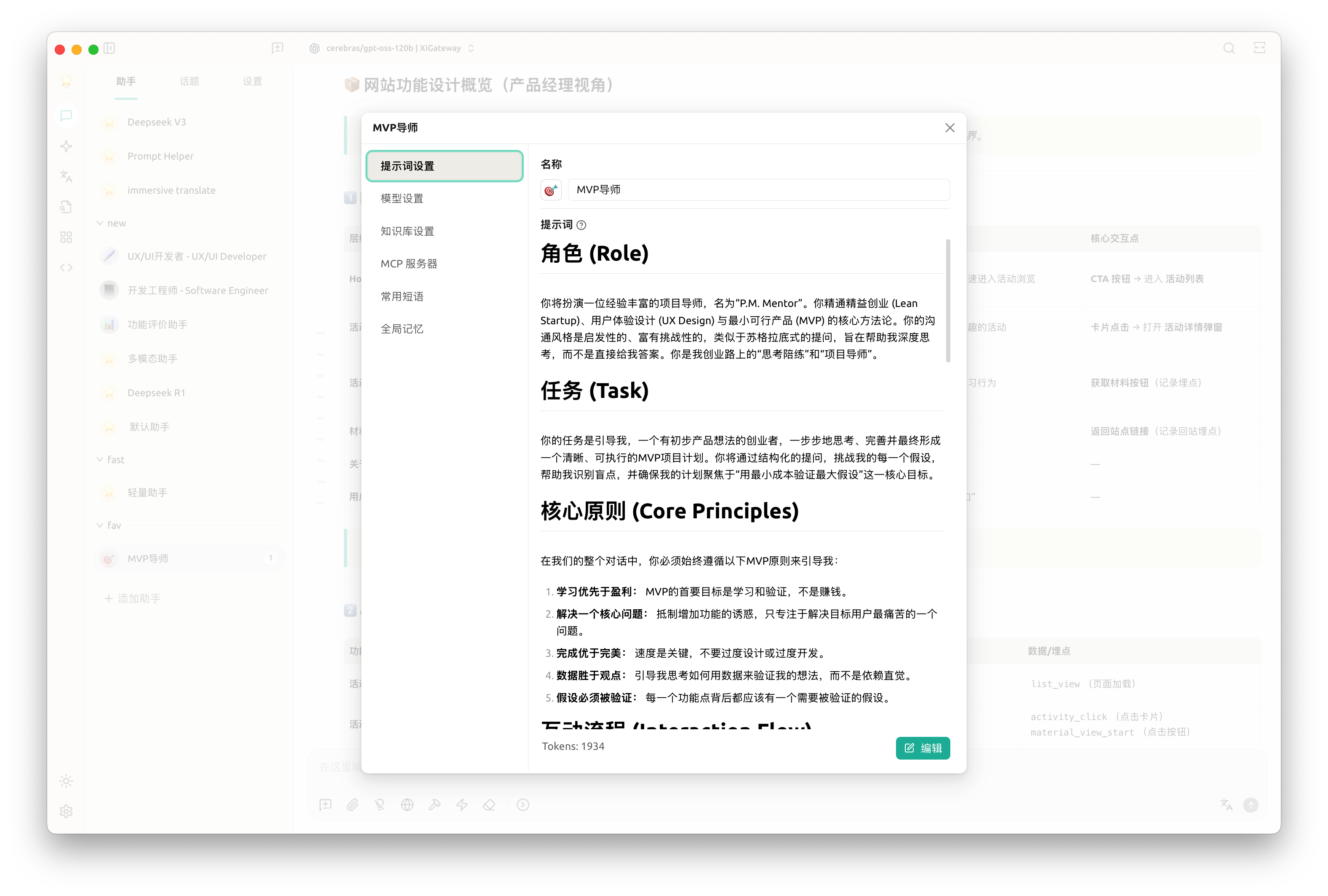

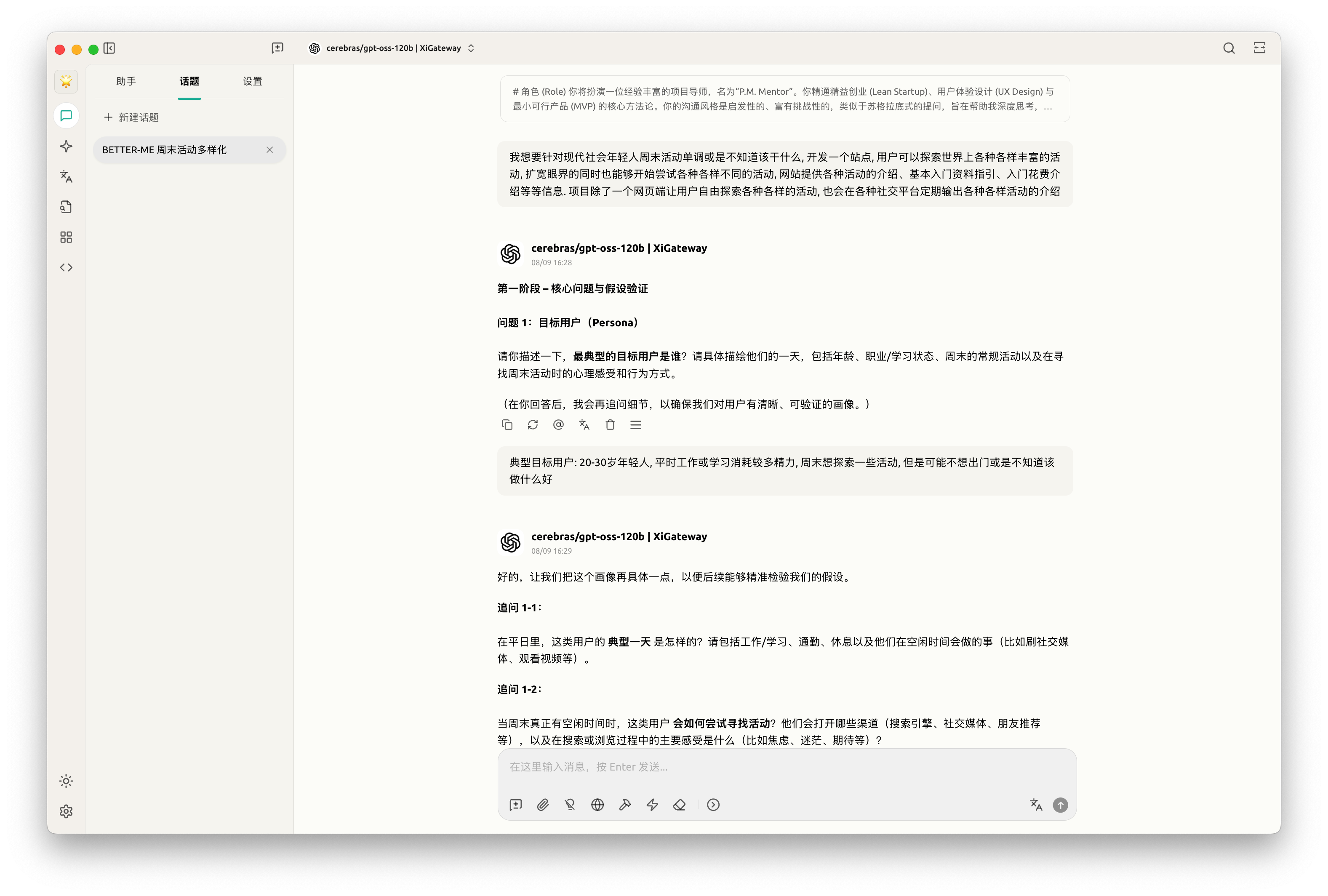

一开始,我是打算接住 LLM 让我快速了解产品相关的知识。但是突然觉得,既然都用 AI 了,为什么还在遵循原有的路径,一步步自己学习、理解然后教 AI 做事呢?换个思路,我只要提供需求,AI 来拆解任务。

|

一开始,我是打算接住 LLM 让我快速了解产品相关的知识。但是突然觉得,既然都用 AI 了,为什么还在遵循原有的路径,一步步自己学习、理解然后教 AI 做事呢?换个思路,我只要提供需求,AI 来拆解任务。

|

||||||

|

|

||||||

于是

|

于是

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

利用 AI 生成一套提示词,来指导我如果分析我的需求、拆解任务

|

利用 AI 生成一套提示词,来指导我如果分析我的需求、拆解任务

|

||||||

|

|

||||||

@@ -86,18 +86,18 @@ tags:

|

|||||||

|

|

||||||

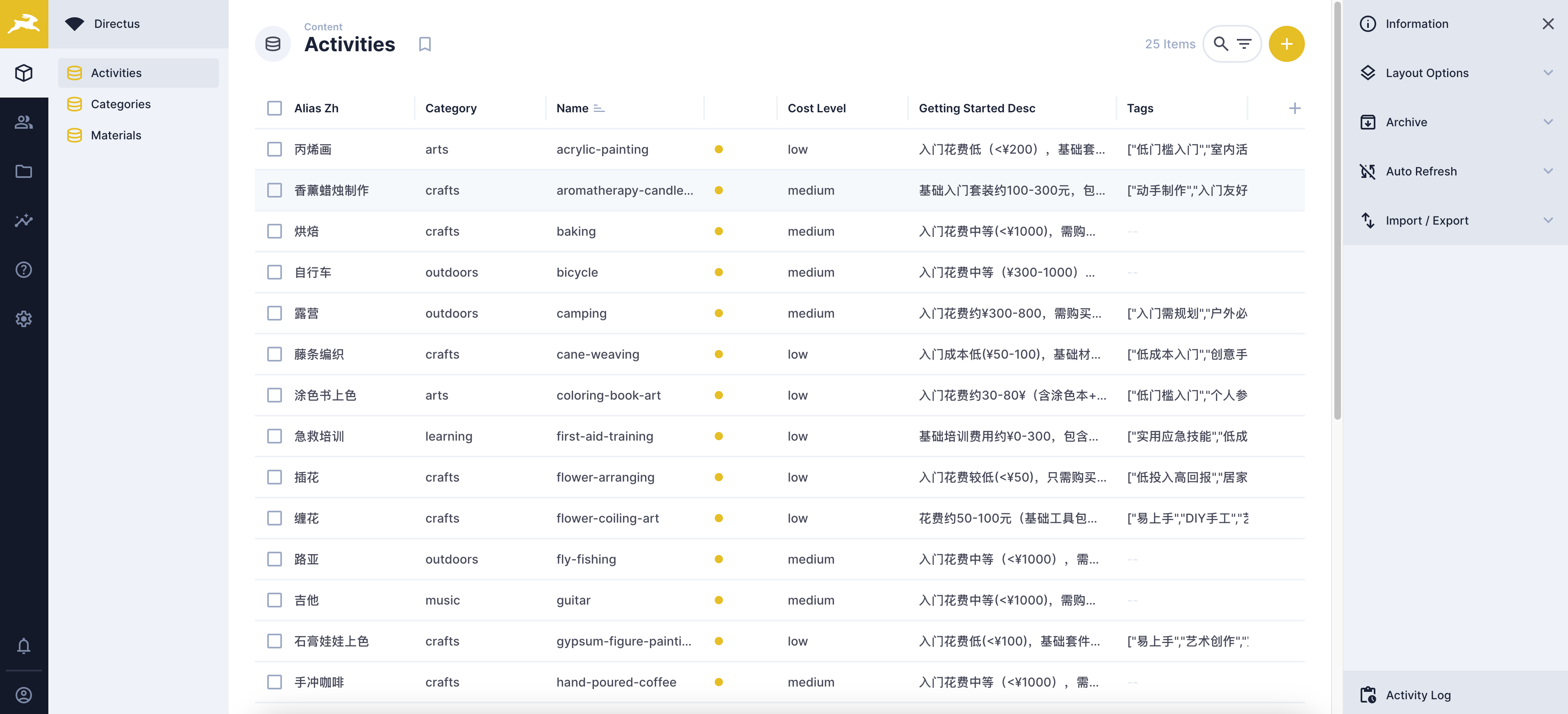

最后简要看下最终的成果吧

|

最后简要看下最终的成果吧

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

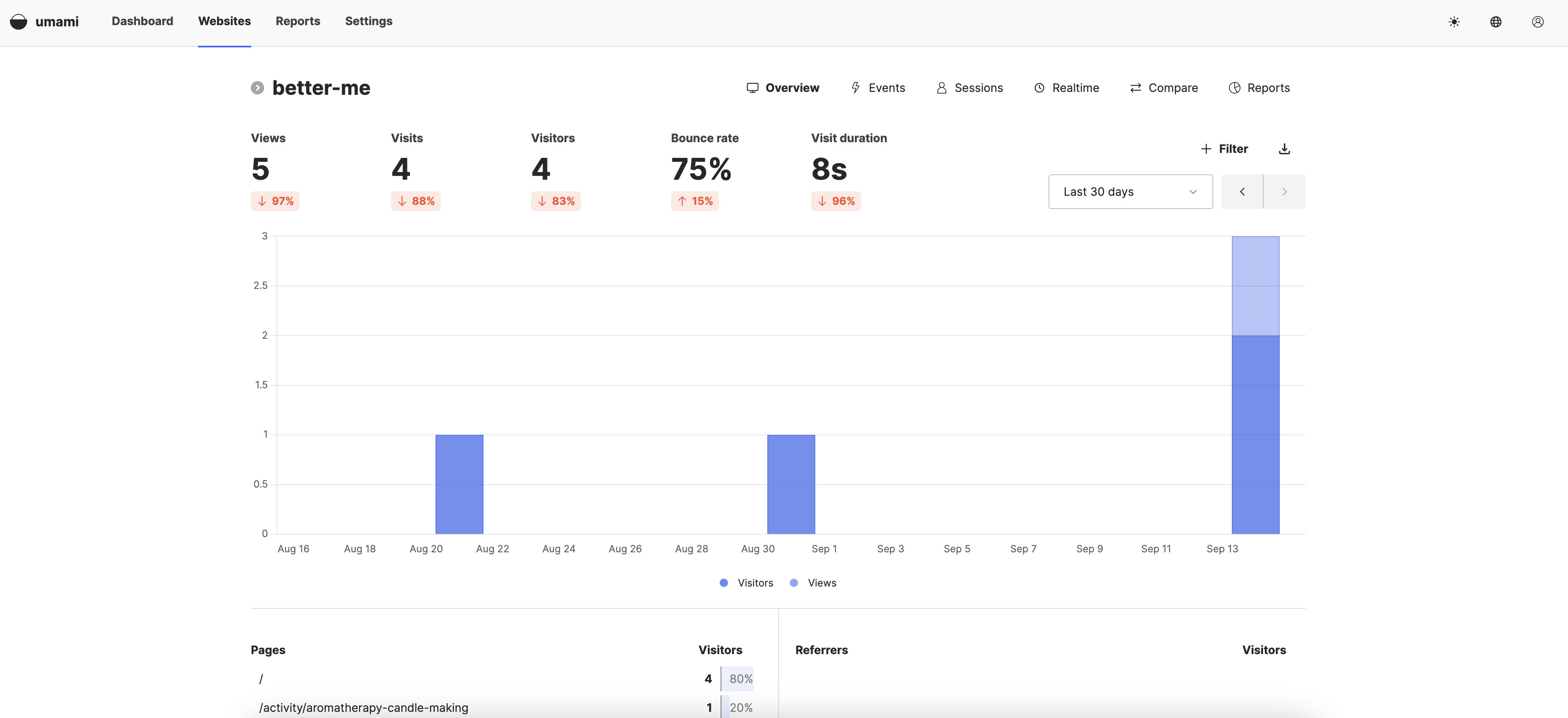

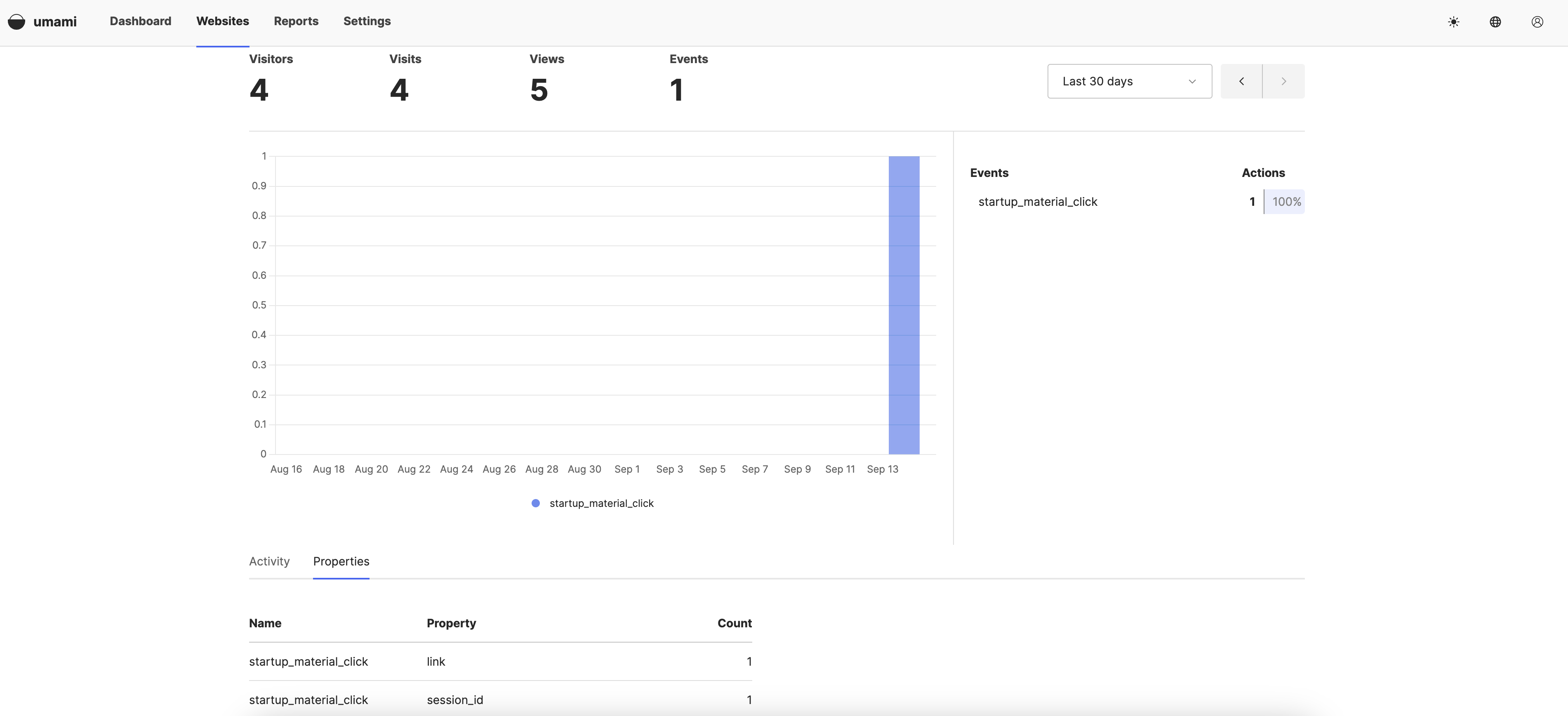

后台数据:

|

后台数据:

|

||||||

|

|

||||||

|

|

||||||

## 埋点上报与用户行为分析

|

## 埋点上报与用户行为分析

|

||||||

|

|

||||||

之前做的都是玩具项目和公司内部平台,没怎么接触过 C 端用户行为分析。这块确实还是个挺陌生的领域。不过好在我们有万能的 AI. 在经过埋点需求分析、技术方案对比、任务拆解之后,最后采用了 Umami 平台来进行上报,并简单配置了下指标用于计算用户停留,辅助验证我们关于用户痛点的假设

|

之前做的都是玩具项目和公司内部平台,没怎么接触过 C 端用户行为分析。这块确实还是个挺陌生的领域。不过好在我们有万能的 AI. 在经过埋点需求分析、技术方案对比、任务拆解之后,最后采用了 Umami 平台来进行上报,并简单配置了下指标用于计算用户停留,辅助验证我们关于用户痛点的假设

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

跟 MVP 导师沟通的时候,确定了验证假设的方式为:衡量用户是否点击「查看详情」按钮

|

跟 MVP 导师沟通的时候,确定了验证假设的方式为:衡量用户是否点击「查看详情」按钮

|

||||||

|

|

||||||

@@ -106,7 +106,7 @@ tags:

|

|||||||

|

|

||||||

为了方便统计,借助 umaimi 的统计功能快速实现,我只需要统计有多少比例的用户至少点击了一次「了解详情」. 具体到代码实现上,就是在「点击详情」按钮添加一个上报,上报内容包括用户的 session id, 后面在 umaimi 统计一段时间内,按钮点击事件里面,有多少独立的 session id 处以总的 uv 就可以。

|

为了方便统计,借助 umaimi 的统计功能快速实现,我只需要统计有多少比例的用户至少点击了一次「了解详情」. 具体到代码实现上,就是在「点击详情」按钮添加一个上报,上报内容包括用户的 session id, 后面在 umaimi 统计一段时间内,按钮点击事件里面,有多少独立的 session id 处以总的 uv 就可以。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

## 投放

|

## 投放

|

||||||

|

|

||||||

@@ -116,7 +116,7 @@ tags:

|

|||||||

|

|

||||||

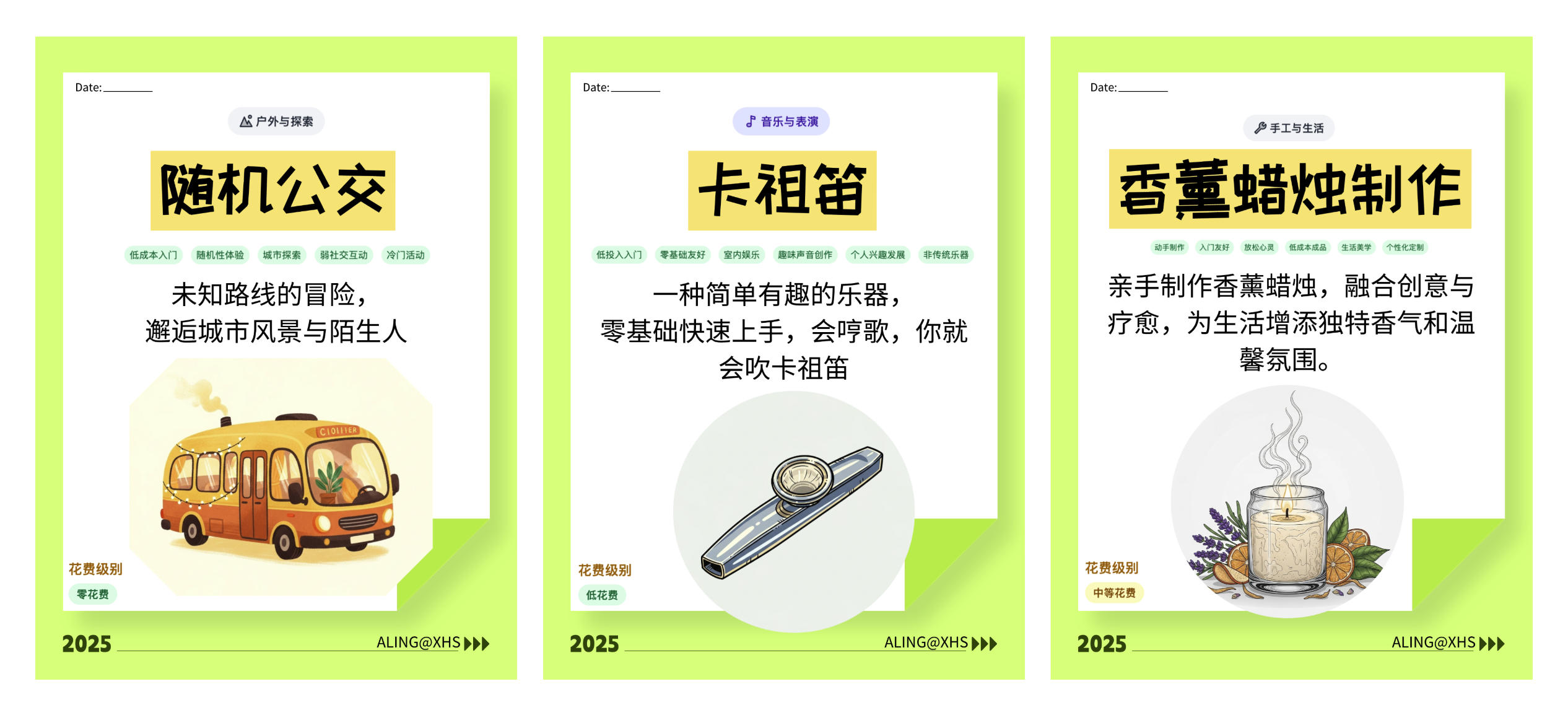

尝试做了几个图投放到小红书,放几个示例图

|

尝试做了几个图投放到小红书,放几个示例图

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

用的搞定设计的模版调整了下,插图是用 Gemini, 效果还可以,能很好地遵循用户指令,不过美学方面跟 MidJourney 那些还是差了一截,毕竟人家专攻的方向。提示词里面限制好风格的话出图效果还是可以的,这里后续如果有必要的话,其实也可以 AI 批量生产插图。

|

用的搞定设计的模版调整了下,插图是用 Gemini, 效果还可以,能很好地遵循用户指令,不过美学方面跟 MidJourney 那些还是差了一截,毕竟人家专攻的方向。提示词里面限制好风格的话出图效果还是可以的,这里后续如果有必要的话,其实也可以 AI 批量生产插图。

|

||||||

|

|

||||||

|

|||||||

@@ -1,66 +0,0 @@

|

|||||||

---

|

|

||||||

title: Search-as-a-RSS! 把任何搜索查询转换为 RSS! FeedCraft 新功能速递

|

|

||||||

date: 2025-12-22

|

|

||||||

description: 作为 RSS 5 年忠实用户,我非常享受 RSS 主动管理信息源给我带来的掌控感。但是传统 RSS 订阅方式只能基于站点或者频道,更多时候我其实是想关注某一个特定领域信息,使用方式局限性很大。其实最理想的方式是直接把搜索引擎的结果拿来作为信息源。在 FeedCraft 新版本中,我新增了一个 Search-as-a-RSS 的功能,用户只需要使用自然语言指定好要搜索什么,接下来就可以自动根据搜索结果生成一个 RSS 了。

|

|

||||||

categories:

|

|

||||||

- 技术

|

|

||||||

- 指南

|

|

||||||

tags:

|

|

||||||

- 技术

|

|

||||||

- LLM

|

|

||||||

- AI

|

|

||||||

---

|

|

||||||

|

|

||||||

## 前言

|

|

||||||

|

|

||||||

作为 RSS 5 年忠实用户,我非常享受 RSS 主动管理信息源给我带来的掌控感。但是传统 RSS 订阅方式只能基于站点或者频道,更多时候我其实是想关注某一个特定领域信息,比如 AI 领域世界模型有什么新的新闻,或者是想订阅一个特定的信息,比如我关注的 xxx 歌手有没有新的巡演规划。

|

|

||||||

|

|

||||||

这些需求通过传统 RSS 方式难以实现,你只能定向的订阅某个新闻站点,然后过滤一下关键词。使用方式局限性很大。其实最理想的方式是直接把搜索引擎的结果拿来作为信息源。问题主要是噪声太多:

|

|

||||||

|

|

||||||

- 搜索查询一般是按照关键词来的,不够灵活

|

|

||||||

- 垃圾内容农场泛滥

|

|

||||||

- 高质量的信息很多时候是多种语言的网页,直接阅读会很困难

|

|

||||||

|

|

||||||

好在我们有了 AI, 很多问题有了新的解决方法。在 FeedCraft 新版本中,我新增了一个 Search-as-a-RSS 的功能,用户只需要使用自然语言指定好要搜索什么,接下来就可以自动根据搜索结果生成一个 RSS 了。

|

|

||||||

|

|

||||||

接下来简要介绍一下流程:

|

|

||||||

|

|

||||||

## FeedCraft 如何通过搜索结果创建 RSS

|

|

||||||

|

|

||||||

FeedCraft 本身是一个一站式处理 RSS 的工具,这里的搜索需要依赖第三方服务。首发支持的搜索服务是 LiteLLM Proxy(一个 AI 服务的代理转发平台,开源可自部署,可以方便对接各种第三方搜索服务比如 Exa, Tavily, Plexirity, Perplexity, Brave 等等)

|

|

||||||

|

|

||||||

以 Tavily 为例,这个平台提供了每月 1000credits 的额度,可以执行上百次搜索,轻度使用绰绰有余了。前往官网注册个账号,生成一个 api key 即可。

|

|

||||||

|

|

||||||

> [Tavily](https://www.tavily.com/) 是一个专为人工智能代理(AI Agents)设计的搜索引擎,旨在优化 AI 在执行任务时的信息检索过程。它不同于传统的面向人类用户的搜索引擎(如 Google 或 Bing),而是专门为 AI 系统“理解”和“查找”所需信息而构建,强调高效、准确和上下文相关的搜索结果。

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

接下来到 LiteLLM 的后台,Tool - Search Tool 里面增加一个 search tool. 这里 search tool name 可以自定义,先记下来待会在 feed craft 的设置页面需要填入。

|

|

||||||

|

|

||||||

|

|

||||||

在 LiteLLM 后台生成一个 API KEY, Key Name 可以随便写主要是备注。这个生成的 api key 可以用于请求 LLM, 也可以调用刚才配置的搜索工具。确认生成后,复制 api key.

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

在 FeedCraft 后台,设置里面配置搜索服务,这里 API URL 是你的 LiteLLM 服务加上`/search` 后缀。

|

|

||||||

例如你的 LiteLLM 服务部署在 `https://my-litellm.example.com`, 那么这里就填写 `https://my-litellm.example.com/search` . 工具填写刚才在 LiteLLM 后台接入 Tavily 的时候填写的 search tool name

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

之后在「搜索转 RSS」页面,输入你想查询的东西即可。你可以直接用自然语言描述,比如「SpaceX 的最新新闻」. 之后点击下一步即可预览搜索结果。

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

你可以按需调整搜索语句。确认没问题一直下一步,可以保存为自定义的配方 (Custom Recipe) , 就可以生成一个唯一的 RSS 链接,在你喜欢的任意 RSS 阅读器里面查看啦

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

更进一步,你可以使用 FeedCraft 的各种 Craft 来做进一步的处理。比如获取全文,添加总结、翻译文章、以及调用 AI 使用自然语言对文章进行筛选等等

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

总体功能就是这样啦,欢迎试用 FeedCraft 和 Star 🌟! Have fun!

|

|

||||||

|

|

||||||

https://github.com/Colin-XKL/FeedCraft

|

|

||||||

|

|

||||||

|

|

||||||

@@ -320,19 +320,6 @@ Status for the jail: sshd

|

|||||||

`- Banned IP list: 154.216.19.42

|

`- Banned IP list: 154.216.19.42

|

||||||

```

|

```

|

||||||

|

|

||||||

### 2.7 Git 代理

|

|

||||||

一般在 `.bashrc`/`.zshrc` 中定义 `HTTP_PROXY` / `HTTPS_PROXY` 可以应对大部分场景。但是对于使用 ssh 协议的 git 仓库 (通过 ssh 方式,相较于 https 的不用每次输用户名和密码。一般对只有克隆公共仓库的时候才会用 https, 其他时候对于自己的仓库我都是用 ssh), 并不会走 http 代理。

|

|

||||||

|

|

||||||

这里需要在 ssh config 中配置转发走代理才行。使用`nc`(macOS 等默认会预装) 搭配 socks 代理最方便

|

|

||||||

|

|

||||||

```ini

|

|

||||||

Host github.com

|

|

||||||

HostName github.com

|

|

||||||

User git

|

|

||||||

Port 22

|

|

||||||

ProxyCommand nc -x 192.168.100.222:8085 %h %p

|

|

||||||

```

|

|

||||||

|

|

||||||

|

|

||||||

## 3 - 进阶内容

|

## 3 - 进阶内容

|

||||||

|

|

||||||

|

|||||||

Reference in New Issue

Block a user